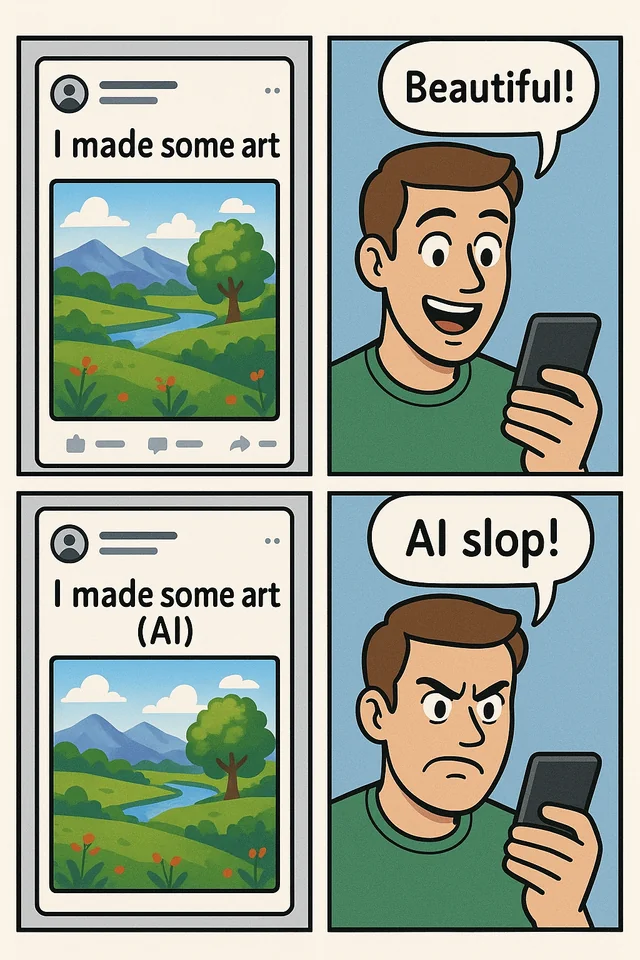

Was ist AI Slop?

Der Begriff AI Slop, zu Deutsch so viel wie „KI-Schrott“, bezeichnet KI-generierte, belanglose oder qualitativ minderwertige Inhalte, die im Internet verbreitet werden und ein zunehmendes Problem darstellen. Die Inhalte werden mithilfe grosser Sprachmodelle (LLM) erstellt und umfassen Bilder, Videos, Texte und Musik. Der entscheidende Faktor für diese Bezeichnung: Die Inhalte weisen meist eine minderwertige Qualität auf und werden en masse mit wenig Kontrolle oder Überprüfung kreiert und es ist kaum ein Mehrwert erkennbar.

Der Kern dieser Inhalte ist die schnelle Generierung von Aufmerksamkeit und Reichweite – und damit Profit. Die resultierende Masse an fehlerhaften oder irreführenden Beiträgen senkt die inhaltliche Qualität von Plattformen wie TikTok, YouTube und Meta insgesamt und führt zu einem spürbaren Vertrauensverlust bei Nutzern. Denn: Viele Menschen tun sich schwer, KI-Inhalte entsprechend zu identifizieren und von Artikeln, die von realen Autoren erstellt wurden, zu differenzieren. Die KI-Inhalte finden sich in allen Bereichen und können von jedem individuell erstellt werden, per KI-Tools und unter Einsatz generativer KI. Die Ergebnisse weisen meist ähnliche Eigenschaften auf, hier die prägnantesten AI-Slop-Merkmale einmal zusammengefasst:

Klassische AI-Slop-Beispiele

KI-Slop findet sich in allen Bereichen online: AI Music auf Streaming-Plattformen, halluzinierte Quellen und „Fakten“ in KI-generierten Artikeln, KI-basierte Fake News. Viele der Inhalte unterscheiden sich kaum voneinander, etwa generische Reisevideos ohne echten Bezug oder KI-Bilder, die immer wieder dieselben Muster reproduzieren. Das wohl bekannteste Beispiel für AI-Slop ist der „Shrimp-Jesus“, eine surreale, KI-generierte Grafik, die einen aus Garnelen geformten Jesus abbildet.

Weitere typische Formen von AI-Slop lassen sich in vielen Content-Kategorien beobachten:

- Gefälschte Statements und Deepfake-Clips von Politikern oder Prominenten

- KI-generierte Fantasie-Tiere und Architektur

- Pseudo-Wissensvideos mit KI-Stimmen

- Generische Produktreviews oder erfundene Testimonials

AI-Slop-Inhalte sagen bei genauerer Betrachtung nichts Sinnvolles aus und fordern stattdessen zu reinem Konsum auf.

Was ist der Zweck von AI Slop?

AI Slop dient primär dem wirtschaftlichen Zweck der Profitgenerierung, wobei durch massenhafte, kostengünstige Produktion von Inhalten maximale Reichweite und Engagement auf Social-Media-Plattformen erzeugt werden. Webseitenbetreiber oder Bots greifen auf KI-Tools wie ChatGPT oder Midjourney zurück, um Inhalte in grossen Mengen zu erstellen und zu verbreiten. Die wachsende Menge minderwertiger KI-Inhalte stärkt die Argumentation von KI-Kritikern für weitreichende Regulierungen, was die Einführung qualitativ hochwertiger und produktiver KI-Anwendungen entsprechend verlangsamt.

Die häufigsten Motive hier einmal zusammengefasst:

- Monetarisierung: Automatisierte Posts zielen auf Werbeeinnahmen oder Affiliate-Links ab, indem sie möglichst viral gehen sollen

- Skalierung: Suchmaschinen und Feeds werden mit irrelevantem Material überschwemmt, um maximale Sichtbarkeit zu sichern, ohne dass viel Personal dafür eingesetzt wird

- Manipulation: Inhalte dienen in manchen Fällen auch dem Betrug, darunter z.B. emotional aufgeladene Fake-Bilder für Klicks oder politisch verzerrte Darstellungen

- Prototyping: Der geringe Aufwand erlaubt es, in Masse neue Formate oder Ideen zu testen

Ohne kritische Reflexion und Nutzung mit Vorsicht drohen Fehlinformationen und Vertrauensverlust. Während sich der Zweck von AI Slop vor allem auf schnelle Skalierung und monetären Gewinn beläuft, entsteht das eigentliche Problem dadurch, wie die Inhalte verbreitet und algorithmisch verstärkt werden und digitale Bereiche beeinflussen.

Der AI-Slop Prozess

Zu Beginn steht der Aufbau von Social-Media-Profilen, oder die Verwendung von Profilen, die bereits über Reichweite verfügen. Darüber lassen sich generierte Inhalte sofort an ein grosses Publikum ausspielen. Unter Einsatz von KI-Tools werden schnell und in grossen Mengen visuell herausstechende Inhalte erstellt und auf diesem Weg verbreitet. Je viraler oder beliebter der Content bei den Nutzern der Plattform ist, desto besser ist die Monetarisierung. Das kann etwa über Boni der Plattform für virale Posts, über Affiliate-Links, aber auch durch den Vertrieb von Kursen und Materialien zur Schulung zur Erstellung solcher Inhalte erfolgen.

Besonders Social-Media-Feeds werden mit KI-generierten Inhalten geflutet, die durch visuelle Plausibilität den Algorithmus austricksen. Dieser Prozess wird durch sogenannte „Agentic AI Accounts“ (AAA) vorangetrieben. Die AI-Forensics-Studie „AI Generated Algorithmic Virality“ (2025) beschreibt die Folgen dieser automatisierten Social-Media-Accounts und deren Nutzung generativer KI-Tools, um Content-Erstellung und Postings ganz oder teilweise zu automatisieren. Ein Account gilt dabei als „agentic“, wenn die letzten 10 Beiträge ausschliesslich aus KI-generierten Bildern bestehen, auch wenn zuvor manuell erstellte Inhalte gepostet wurden. Mit der Zunahme dieser Accounts wird die Inhaltsproduktion grundlegend verändert und Plattformen werden anfälliger für Desinformation und Qualitätsverlust. Der Prozess des AI Slops schafft einen selbstverstärkenden Kreislauf: Plattformen priorisieren Engagement, Slop dominiert die Suchergebnisse und verdrängt menschliche, qualitativ hochwertige Inhalte.

Was sind die Auswirkungen von AI Slop?

Die schwerwiegendsten Auswirkungen von AI Slop sind folgende:

- Qualitäts- und Vertrauensverlust: Glaubwürdigkeit von Marken und Medien wird zunehmend untergraben

- Desinformation und Extremismus: Falschnachrichten und extreme Weltbilder verbreiten sich schneller und unkontrollierter

- Kultureller Verlust: Originelle Werke werden überlagert und originelle, kreative Inhalte verlieren an Sichtbarkeit

- Kognitive Belastung: Aufmerksamkeitsspanne und Urteilsvermögen leiden unter der anhaltenden Reizüberflutung

- Ökologische Kosten: Die massenhafte Erzeugung automatisierter Inhalte steigert den Energieverbrauch und belastet Ressourcen

Neben dem Verlust an Qualität führt AI-Slop zunehmend zu einem erheblichen Vertrauensverlust bei Nutzern und Marken, da es immer schwieriger ist, zu erkennen, was wahr und was falsch ist. Die Konzentration auf Masse und Geschwindigkeit bei der KI-gestützten Inhaltserstellung verwischt das Besondere, während zugleich originelle menschliche Werke oft ohne Zustimmung oder Vergütung für das Training von KI genutzt werden. Aufgrund der unklaren Differenzierung von KI-Inhalten wird die Wahrnehmung von Kultur und Werken in Kunst und Musik stark beeinträchtigt.

Schwerwiegende Folgen sind zudem der Missbrauch von Inhalten und die vereinfachte Verstärkung extremer Weltbilder. Konventionellen Medien wird die Durchsetzung gegen die Flut KI-generierter, oftmals falscher Nachrichten erschwert. Desinformation und Fake News gewinnen an Verbreitung. Zudem werden die Aufmerksamkeitsspanne und das menschliche Denkvermögen belastet, was die Differenzierung menschlicher Inhalte weiter beschränkt. Online beschreiben Nutzer den Effekt von AI Slop als „Breaking the Internet“ (Kurzgesagt, 2025), d. h., das Internet würde durch die Flut an schädlichen oder minderwertigen Inhalten zerstört. AI Slop stellt somit metaphorisch betrachtet eine Art „Mikroplastik des Internets“ (Jochen Dreier, Deutschlandfunk) dar, es verbreitet sich rasant und kleinteilig und birgt unterschätzte Gefahren. Der Blick auf wertvolle Werke wird durch die Überflutung mit belanglosem Content verstellt und gesellschaftliche Diskussionen über Wahrheit und Meinungen werden erschwert. Nicht zuletzt hat der AI Slop auch ökologische Konsequenzen durch den hohen Energieverbrauch bei der massenhaften Inhaltsgenerierung.

Nutzerpräferenzen: Ein Beispiel mit Dall-E

Ein Test mit Dall-E, dem Bildgenerierungstool von OpenAI, zeigte interessante Einblicke in Nutzerpräferenzen bei KI-generierten Bildern. 50 menschliche Kunstwerke wurden beschrieben und von der KI nachgestellt (Forschung Januar 2025). Viele Teilnehmer konnten zwar meist zwischen den originalen Werken und den KI-generierten unterscheiden, dennoch fanden sie die KI-Bilder oft ansprechender und bevorzugten diese überraschend häufig. Dies lässt sich durch den sogenannten „Bizarress-Effekt“ erklären, eine psychologische Erkenntnis, laut der skurrile und ungewöhnliche Darstellungen in Bildern, Videos oder Texten dem menschlichen Gehirn stärker zusagen. Solche ungewöhnlichen Stimuli stechen aus der Masse hervor und werden besser im Gedächtnis gespeichert, was die Attraktivität der KI-Kreationen und AI Slop fördert. Es ist dabei zu erwähnen, dass der anfangs reizvolle Bizarreness-Effekt mit der massenhaften Verbreitung ähnlicher KI-Stile schnell an Wirkung verliert und die ungewöhnlichen Reize langfristig weniger ansprechend werden.

Soziale Plattformen als Enabler von AI Slop

Soziale Plattformen nutzen diesen Trend als Enabler von AI Slop, also als Vermittler bzw. Förderer, und verstärken das Problem weiter. Ein Unterbegriff im Kontext von AI Slop ist "Brainrot", zu Deutsch so viel wie verrottendes Gehirn bzw. „Gehirnfäule“, was den Output-Effekt bezeichnet: Nutzer konsumieren oder produzieren derartig übermässigen niedrigschwelligen, repetitiven KI-Content, dass sich Wahrnehmung oder Kommunikationsstil merklich daran anpassen und Konzentrationsverlust und psychischer Belastung folgen. (BBC, 2024)

GRAFIK: „AI Slop vs. Brainrot – Qualität und Sinn in KI-Inhalten“

Die Algorithmen hinter den sozialen Netzwerken tun alles, um den Nutzer möglichst lange am Bildschirm zu halten. Hier wirkt AI Slop sehr stark und Content wird ununterbrochen vorgeschlagen. Die Content-Erstellung ist extrem günstig, die Überprüfung der Inhalte hingegen teuer und aufwändig. Es mangelt an klaren Redaktionsprozessen zur Sicherstellung der Relevanz und Qualität von Inhalten. Je mehr AI-Slop-Content ausgespielt wird, desto stärker basieren neue Inhalte auf diesem, ein Schleifeneffekt. Besonders Meta steht hier stark in der Kritik (Facebook und Instagram). Die Plattform fördert aktiv AI Slop, indem Meta Nutzern zunehmend Inhalte auf Basis der KI-Empfehlungen vorschlägt. Zusätzlich bietet Meta diverse eigene KI-Tools zur Generierung von KI-Inhalten an.

„Auf Facebook, Instagram und Threads liefern unsere KI-Empfehlungssysteme qualitativ hochwertigere und relevantere Inhalte. (…) Die Verbesserungen unserer Empfehlungssysteme werden mit zunehmendem Volumen der KI-generierten Inhalte noch stärker zum Tragen kommen.“

Mark Zuckerberg im Third-Quarter-2025-Results-Conference-Call, Oktober 2025

Plattformen wie Meta, aber auch YouTube und TikTok haben weiterhin Monetarisierungsprogramme eingeführt, die Creator für virale Inhalte belohnen und damit AI Slop massiv anregen. Der KI-Content kann schnell und günstig skaliert werden, die Partnerprogramme zahlen dabei für Views und Engagement.

Was kann man also tun? Tipps gegen AI Slop

Plattformen wie Meta und YouTube müssen Algorithmen anpassen, um erkennbaren Mehrwert statt reines Engagement zu priorisieren. Versuche, durch Algorithmus-Anpassungen die Glaubwürdigkeit und redaktionelle Prüfung zu priorisieren, sind erkennbar, allerdings noch lange nicht ausreichend. Massnahmen gegen AI-Slop auf Nutzerseite umfassen technische KI-Detektoren und umfangreiche Qualitätskontrollen bei der Verwendung von Inhalten. Tools wie GPTZero oder Writer.com können eingesetzt werden, um KI-generierte Texte zu identifizieren und typische KI-Muster zu erkennen. Nutzer können in gewissem Masse eigenständig kontrollieren, welche Inhalte ihnen angezeigt werden, indem sie bewusst Content melden oder als „nicht interessiert“ kennzeichnen. Je mehr echte Profile und Creator unterstützt werden, etwa durch Likes, Follows u.Ä., desto weniger AI-Slop wird ausgespielt und konsumiert. Der EU AI Act (seit August 2024 in Kraft) schreibt klare Transparenzpflichten für synthetische Inhalte vor: Generative KI muss Outputs (Text, Bilder, Audio, Video) maschinenlesbar markieren und Deepfakes kennzeichnen. Bei Verstoss drohen Bussgelder bis zu 3 % des globalen Umsatzes. Die AI-Forensics-Studie (2025) zeigt jedoch mangelnde Durchsetzung der Kennzeichnung. Eine umfassende und verpflichtende Labelling-Infrastruktur sowie Audit-Ökosysteme sind entscheidend, um AI Slop einzudämmen.

Fazit

Nur weil Inhalte in Sekundenschnelle erstellt werden können, heisst das nicht, dass dies richtig und wichtig ist. Für Nutzer wird es daher immer essenzieller, den Wert von Content kritisch zu prüfen: Ist der Beitrag ein menschlich erstelltes Werk oder eine KI‑Kreation? Handelt es sich um sinnvolle Inhalte mit passender KI-Unterstützung oder um generierten AI-Slop ohne Mehrwert?

Besonders Unternehmen sollten diesen Unterschied kennen und KI nur dort nutzen, wo sie echte Wirkung entfaltet. Moderne Sprachmodelle (LLM) ermöglichen die schnelle, skalierbare Content-Produktion und Aufbereitung von Inhalten, jedoch nur mit qualitativer Wirkung, wenn sie präzise gesteuert und fachlich geprüft werden. Falsch eingesetzt verstärken sie den Informationsrausch und erschweren das Wissensmanagement.

[[CTA headline="Mit moinAI KI gezielt nutzen und Slop vermeiden!" subline="Präzise Ausgaben die zielführend im Unternehmen wirken: mit moinAI KI Chatbot-Lösungen in Ihr Unternehmen integrieren." button="Jetzt testen!" placeholder="https://hub. /chatbot-erstellen" gtm-category="primary" gtm-label="Jetzt testen!" gtm-id="chatbot_erstellen"]]