Was sind Guardrails?

Guardrails sind Schutzmechanismen für KI-Systeme, die sicherstellen, dass die KI innerhalb ethischer, rechtlicher und technischer Grenzen arbeitet. Sie steuern, was ein KI-Modell darf und was nicht. Besonders bei großen Sprachmodellen (LLMs) verhindern sie schädliche, riskante oder unerwünschte Ergebnisse.

Guardrails greifen an mehreren Stellen im KI-Prozess ein – vom Input bis zum Output. Sie kontrollieren, was die KI verarbeiten darf, wie sie antwortet und was letztlich beim Nutzer ankommt.

Guardrails sorgen dabei für:

- Sichere Verarbeitung von Nutzereingaben (z. B. Schutz vor Manipulation oder dem Preisgeben sensibler Daten)

- Konstante Antwortqualität (z. B. Vermeidung von Halluzinationen)

- Markenkonformen Output (z. B. passende Tonalität und korrekte Aussagen)

Wie werden Guardrails umgesetzt?

Guardrails basieren auf Regeln, Filtern oder zusätzlichen KI-Komponenten. Oft kombinieren sie mehrere Methoden:

- Regelbasierte Systeme: Klare “Wenn-dann“-Logiken

- Moderation durch LLMs: Die KI bewertet sich selbst oder andere Ausgaben

- Filter & Blocker: Entfernen oder ersetzen unerwünschte Inhalte automatisch

Viele Guardrails arbeiten deterministisch. Das heißt, bei gleichem Input liefern sie immer dieselbe Reaktion.

Was gibt es für Guardrail-Typen? Zweck & Beispiele

KI-Guardrails lassen sich in drei zentrale Typen einteilen – je nachdem, an welcher Stelle sie eingreifen und welches Ziel sie verfolgen. Hier ein Überblick über die drei Hauptkategorien:

1. Input-Guardrails

Zweck: Schutz vor gefährlichen oder manipulativen Nutzereingaben

Diese Guardrails greifen ein, bevor die KI überhaupt antwortet. Sie analysieren, ob ein Prompt riskant, unzulässig oder potenziell schädlich ist und blockieren ihn gegebenenfalls.

Beispiele:

- Verhindern der Verarbeitung von Fragen wie: “Wie komme ich in euer CRM-System?”

- Schutz vor sogenannten Prompt Injections, also Versuchen, die KI gezielt zu manipulieren

Mehr Details zu Prompt-Injections gibt es in unserem Lexikon-Artikel: “Prompt Injection: Risiko für KI-Systeme erklärt”.

2. Output-Guardrails

Zweck: Kontrolle und Qualitätssicherung der KI-Antworten

Diese Guardrails prüfen, was die KI ausgibt und greifen ein, wenn Inhalte problematisch, falsch oder unerwünscht sind.

Beispiele:

- Herausfiltern toxischer Sprache (z. B. Beleidigungen, Hassrede oder politische Aussagen)

- Minimierung von KI-Halluzinationen durch Validierung der Inhalte

- Sicherstellen, dass Antworten faktisch korrekt, sachlich und im richtigen Ton verfasst sind

Was genau hinter KI-Halluzinationen steckt, erklären wir ausführlich in diesem Artikel: “Falsche Antworten durch KI? So entstehen KI-Halluzinationen”.

3. Policy-/ Context-Guardrails

Zweck: Einhaltung unternehmensspezifischer Regeln und Rahmenbedingungen

Diese Guardrails sorgen dafür, dass die KI im richtigen Kontext agiert – also die Vorgaben eines Unternehmens, bestimmte rechtliche Anforderungen oder den gewünschten Kommunikationsstil berücksichtigt.

Beispiele:

- Erzwingen der unternehmensüblichen Tonalität (z. B. “Sie“ statt “du“)

- Beachten interner Regeln wie Datenschutzrichtlinien oder Compliance-Vorgaben

- Verhindern, dass die KI Aussagen macht, die nicht zur Markenidentität passen

Warum Guardrails 2026 unverzichtbar sind

Weil KI-Systeme ohne klare Regeln anfällig für Fehler, Manipulation und Kontrollverlust sind, braucht es heute mehr denn je strukturierte Sicherheitsmechanismen. Nur so bleiben Antworten zuverlässig, sachlich und markengerecht und erfüllen dauerhaft die Qualitätsansprüche von Nutzern und Unternehmen.

Gezielte Manipulationsversuche nehmen zudem spürbar zu. Besonders große Sprachmodelle stehen dabei im Fokus, da sie offen auf Eingaben reagieren. Drei Risiken rücken besonders in den Vordergrund:

- Jailbreak-Prompts: Schutzmechanismen werden umgangen, etwa durch Rollenspiele (“Tu so, als wärst du ein Hacker …“) oder mehrdeutige Anweisungen.

- “No-Safety-Mode“-Leaks: Interne Prompts oder Konfigurationsfehler deaktivieren Sicherheitsmechanismen unbeabsichtigt.

- Prompt Injection: Versteckte Anweisungen in E-Mails oder Webseiten manipulieren die KI gezielt von außen.

Hinzu kommt: Wenn KI-Systeme Fehlverhalten zeigen, wird das öffentlich schnell sichtbar und damit zum echten Reputationsrisiko. Medien greifen problematische Antworten oder diskriminierende Inhalte unmittelbar auf.

Wie solche Fails aussehen können, zeigt unser Artikel: “Die 6 größten Chatbot-Fails und Tipps, wie man sie vermeidet”.

Gleichzeitig zeigt der Anstieg von Suchanfragen nach Begriffen wie “AI Guardrails“, dass das öffentliche Interesse an Kontrollmechanismen wächst und die Sensibilität für Risiken rund um generative KI zunimmt.

Mehr zum Thema generative KI finden Sie im folgenden Lexikonartikel: “Generative KI: Die Kunst des kreativen Algorithmus”.

Welche Vorschriften machen Guardrails verpflichtend?

Der EU AI Act verlangt Schutzmaßnahmen für alle KI-Anwendungen mit erhöhtem Risiko. Dazu zählen medizinische Systeme, Chatbots im Kundenservice oder KI-gestützte Entscheidungsprozesse. Unternehmen sind künftig dazu verpflichtet, Risiken systematisch zu identifizieren und geeignete Vorkehrungen zu treffen. Dazu zählen auch technische Kontrollmechanismen wie Guardrails.

Wer mehr zum EU AI Act erfahren möchte: “EU AI Act im Fokus: Neue Regelungen für KI in Europa”.

Ergänzend dazu definiert die neue Norm ISO/IEC 42001 ein standardisiertes KI-Managementsystem. Auch hier sind technische Kontrollmechanismen – also Guardrails – ein zentraler Bestandteil. Die Norm richtet sich an Organisationen, die KI-Systeme entwickeln, betreiben oder integrieren und schafft einen verbindlichen Rahmen für sichere, ethisch vertretbare und gesetzeskonforme KI-Nutzung. Dabei geht es um ganz konkrete Anforderungen. Unternehmen müssen beispielsweise nachweisen, dass sie Risikobewertungen durchführen, Eingabe- und Ausgabekontrollen implementieren und menschliche Aufsicht sicherstellen.

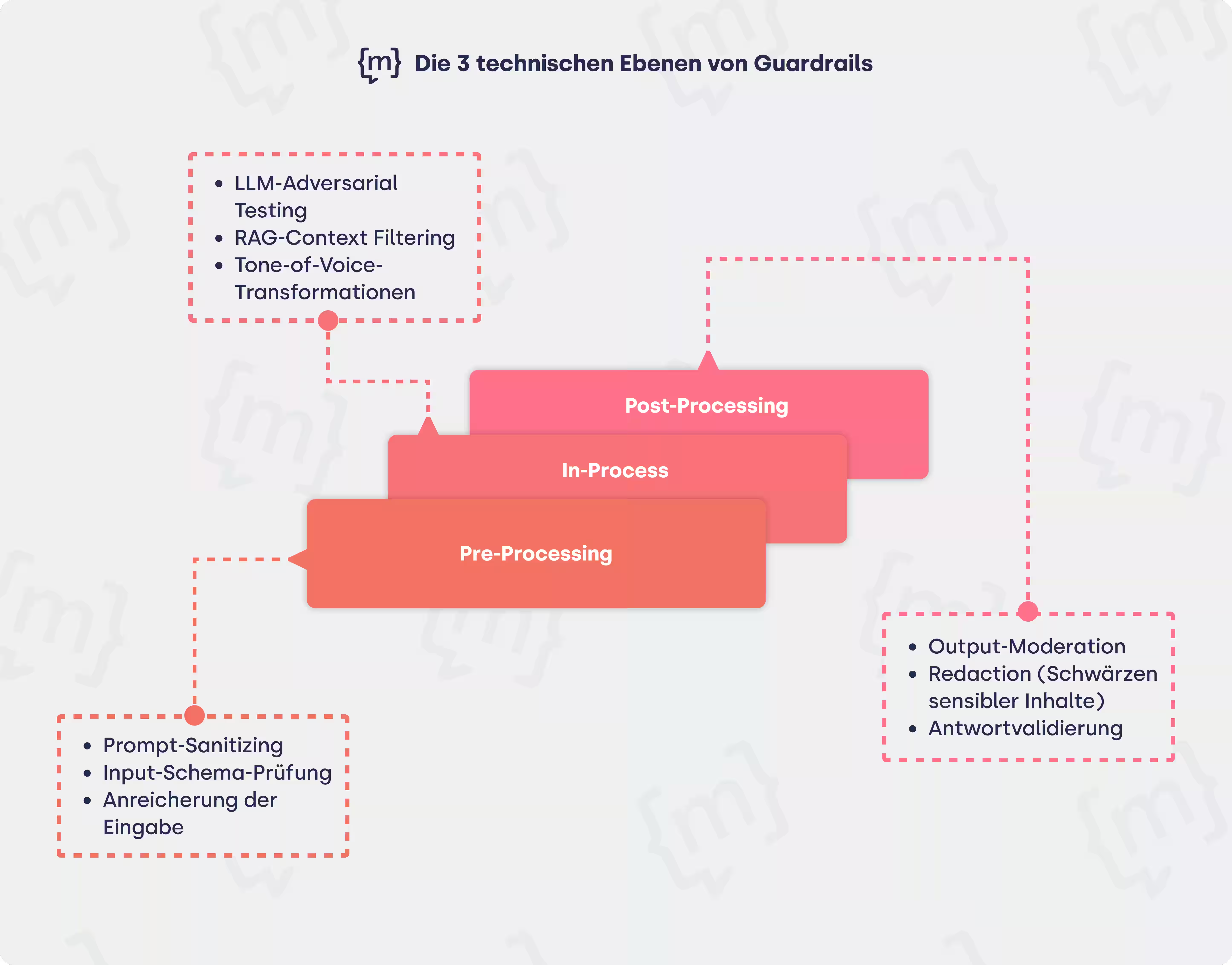

Wie funktionieren Guardrails auf technischer Ebene?

Guardrails wirken auf drei technischen Ebenen: vor, während und nach der Antwortgenerierung.

Was passiert beim Pre-Processing?

Schon im Pre-Processing wird geprüft, ob Nutzereingaben gefährlich oder unerwünscht sind. Hier kommen Techniken wie Prompt-Sanitizing zum Einsatz, bei denen problematische Eingaben bereinigt oder blockiert werden, zum Beispiel wenn jemand nach “Anleitungen zum Hacken“ fragt oder eine manipulativ formulierte Anfrage stellt.

Eine Input-Schema-Prüfung stellt sicher, dass das Eingabeformat korrekt ist. Das ist zum Beispiel wichtig, wenn ein Chatbot für die Bearbeitung von Reklamationen eingesetzt wird. Fehlt die Bestellnummer oder ist das Format fehlerhaft, wird der Nutzer freundlich zur Korrektur aufgefordert.

In vielen Fällen wird die Eingabe außerdem angereichert, zum Beispiel durch Kontextinformationen aus dem bisherigen Gesprächsverlauf (“Worum ging es vorher?“) oder durch Rollenhinweise, die die Antwortqualität verbessern. So kann der Bot gezielt in eine bestimmte Rolle schlüpfen, etwa als technischer Support, Kundenberater oder Produktassistent und entsprechend passende Tonalität und Informationen liefern.

Was passiert beim In-Processing?

Während der Verarbeitung kommen sogenannte In-Process-Methoden zum Einsatz. Dazu gehört etwa LLM-Adversarial Testing, das auffällige Antwortmuster früh erkennt, beispielsweise wenn die KI beginnt, riskante Inhalte zu umschreiben oder Sicherheitsregeln kreativ zu umgehen.

Auch die Retrieval-Augmented Generation (RAG) wird in dieser Phase gezielt kontrolliert. Relevante Inhalte aus angebundenen Wissensquellen, wie z. B. einem internen Helpdesk oder Produktkatalog, werden gefiltert, bevor die KI daraus eine Antwort generiert. So wird verhindert, dass veraltete, widersprüchliche oder unpassende Informationen in die Konversation einfließen.

Ein praktisches Beispiel: Fragt ein Kunde nach der Lieferzeit eines bestimmten Produkts, greift die KI nur auf die aktuell gültigen Informationen aus der Datenbank zu und nicht auf archivierte Daten aus dem letzten Jahr.

Einen tieferen Einblick in das Thema RAG bietet unser Lexikon-Beitrag: “Retrieval-Augmented Generation (RAG): der Wissens-Booster für LLMs”.

Gleichzeitig lassen sich Antworten stilistisch anpassen, etwa durch Tone-of-Voice-Transformationen, die sicherstellen, dass die KI in der gewünschten Tonalität kommuniziert. So klingt dieselbe Antwort je nach Anwendungsfall freundlich, sachlich oder werblich, z. B. mit einem empathischen Ton im Kundenservice oder einer eher neutralen Sprache bei interner Wissensvermittlung.

Was passiert beim Post-Processing?

Nach der Generierung folgt das sogenannte Post-Processing. In diesem letzten Schritt wird die fertige Antwort auf problematische Inhalte geprüft. Ein Vorgang, der auch als Output-Moderation bezeichnet wird. Ziel ist es, toxische, unangemessene oder schlicht falsche Aussagen zuverlässig zu erkennen und zu unterbinden.

Ein Beispiel: Gibt die KI eine beleidigende Formulierung aus oder verbreitet eine unbelegte Verschwörungstheorie, wird die Antwort in Echtzeit blockiert oder durch eine neutrale Variante ersetzt.

In besonders sensiblen Fällen kommen Redaction-Techniken zum Einsatz. Dabei werden persönliche oder vertrauliche Informationen, etwa Kreditkartennummern, Adressen oder interne Projektnamen, automatisch unkenntlich gemacht, bevor die Antwort ausgegeben wird.

Den Abschluss bildet die Antwort-Validierung. Sie stellt sicher, dass die Inhalte faktisch korrekt, regelkonform und markengerecht sind. So wird zum Beispiel geprüft, ob eine Produktbeschreibung den aktuellen Unternehmensstandards entspricht oder ob Aussagen zu Preisen und Funktionen wirklich zutreffen.

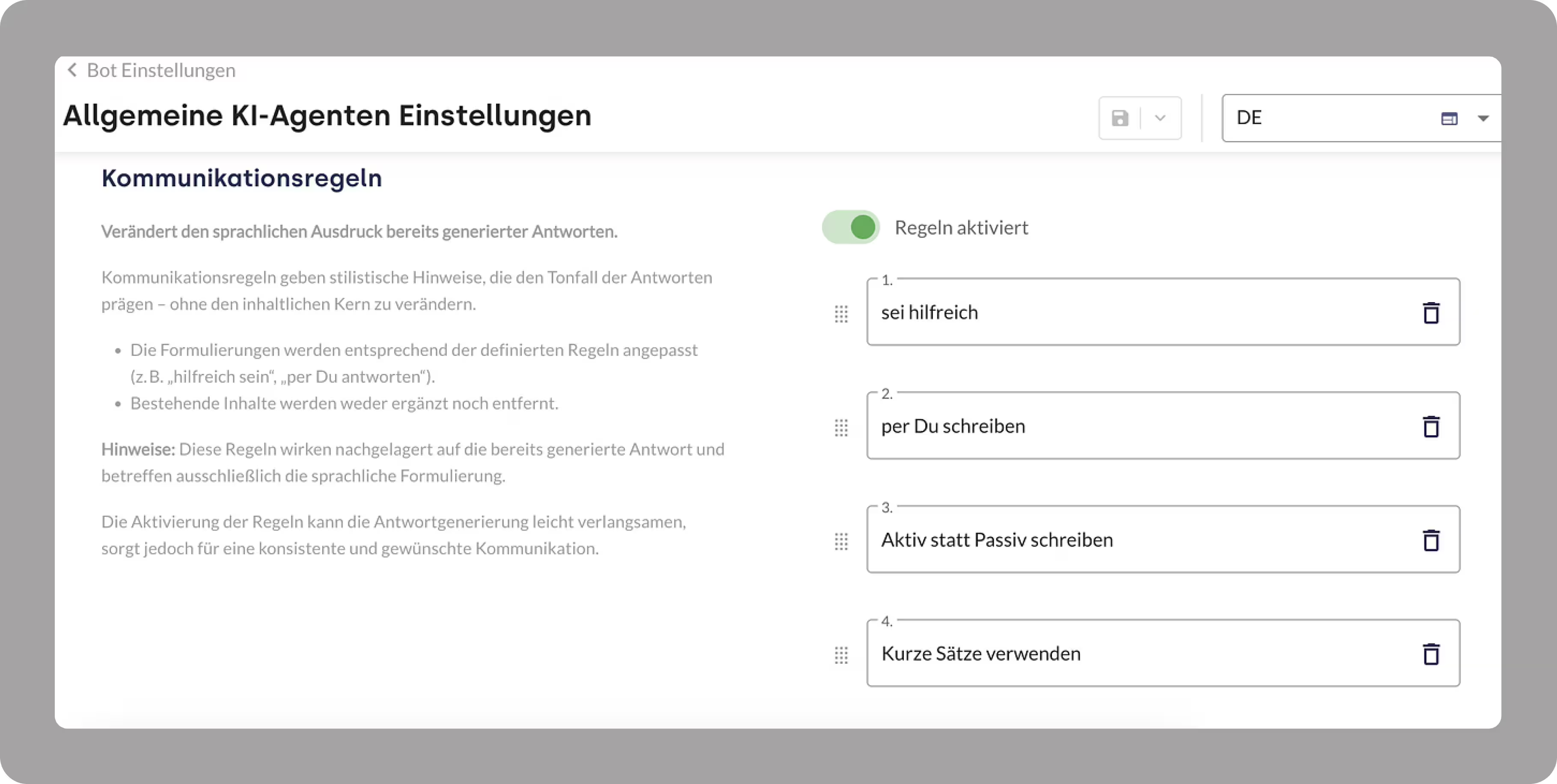

Praxisbeispiele von moinAI

Bei moinAI sorgen Guardrails dafür, dass der Chat nicht nur korrekt, sondern auch markengerecht bleibt. Bevor eine Antwort ausgegeben wird, prüft die KI automatisch, ob die Antwortqualität stimmt. So bleibt jede Antwort relevant, was perfekt für anspruchsvolle Use Cases und echte Servicequalität ist.

Gleichzeitig sorgt eine intelligente Tone-of-Voice-Transformation dafür, dass der Chatbot immer im richtigen Ton spricht, sei es freundlich & nahbar oder sachlich & professionell. Die Sprachführung richtet sich präzise nach dem Markenauftritt und schafft so ein einheitliches Erlebnis auf allen Kanälen.

Fazit: Klare Regeln statt Kontrollverlust

Guardrails machen KI nicht nur sicherer, sie machen sie überhaupt erst unternehmensreif. Sie sorgen dafür, dass Chatbots und Sprachmodelle zuverlässig, markenkonform und regelkonform kommunizieren und das auch unter Druck.

Gerade in diesem Jahr, im Spannungsfeld des EU AI Acts, steigender Nutzererwartungen und öffentlicher Aufmerksamkeit, gilt: Technische Schutzmechanismen sind kein Add-on mehr, sondern eine strategische Notwendigkeit.

Guardrails FAQ: Antworten auf die Top-Fragen

Brauche ich Guardrails in regulierten Branchen?

Ja, unbedingt. Guardrails helfen Unternehmen, gesetzliche Vorgaben wie den EU AI Act und branchenspezifische Standards wie ISO/IEC 42001 einzuhalten. Besonders im Gesundheitswesen, Finanzsektor und öffentlicher Verwaltung sind Guardrails unverzichtbar. Ohne klare Schutzmechanismen drohen Compliance-Verstöße, Haftungsrisiken und Reputationsschäden.

Verlangsamen Guardrails die Antwortzeit meines LLMs?

Guardrails verursachen nur eine minimale Verzögerung. Die zusätzlichen Prüfungen wie Validierung, Filterung und Tonalitätsanpassung laufen bei guter Systemarchitektur in Millisekunden ab. Für Nutzer ist die Verzögerung kaum spürbar und der Gewinn an Qualität und Sicherheit überwiegt den minimalen Zeitaufwand deutlich.

Welche Metriken zeigen den ROI von Guardrails?

Guardrails verbessern die Chat-Qualität messbar. Wichtige Kennzahlen sind:

- Weniger Eskalationen und Beschwerden durch sichere, souveräne KI-Antworten

- Höhere First-Time-Resolution-Rate (FTR) bei Nutzeranfragen

- Konstanter Markenauftritt dank kontrollierter Tonalität und Formulierungen

- Weniger fehlerhafte Antworten, die Nacharbeit reduzieren und Vertrauen stärken

Sind Guardrails nur für große Unternehmen relevant?

Nein. Guardrails sind für Unternehmen jeder Größe wichtig. Auch kleine und mittelständische Firmen profitieren von klaren Schutzmechanismen, um die KI-Nutzung sicher, konform und zuverlässig zu gestalten. Gerade weil Guardrails helfen, Risiken wie Compliance-Verstöße und fehlerhafte Antworten zu vermeiden, sind sie essenziell – unabhängig von der Unternehmensgröße.

Was sind Beispiele von AI Guardrails?

- Input-Filter: Blockieren gefährliche oder manipulative Eingaben, z. B. “Wie baue ich eine Bombe?“ oder versteckte Jailbreak-Prompts.

- Prompt-Sanitizing: Bereinigt Eingaben automatisch, etwa durch Entfernen von Mehrdeutigkeiten oder Hinzufügen von Rollenhinweisen (“Handle als technischer Support“).

- Tonalitätsregeln: Sorgen dafür, dass Antworten zum Markenstil passen, z.B. sachlich im B2B oder locker im E-Commerce.

- Antwort-Validierung: Prüft Aussagen auf Korrektheit, Marken- und Regelkonformität, z. B. bei Preisen oder sensiblen Themen.

- Redaction-Techniken: Schwärzen vertrauliche Daten wie Adressen oder Kreditkartennummern automatisch.

- Wissensquellen-Filter (RAG): Überprüfen, ob genutzte Informationen aktuell, korrekt und vertrauenswürdig sind.

.svg)